Nuove tecnologie e intelligenza artificiale.

Esperienza del limite e desiderio di infinito

Cuneo 21-24 Settembre 2023

Relazione del professore

Andrea Bonarini

all’Incontro nazionale di studi delle Acli nazionali

APPRENDERE DIGITALE

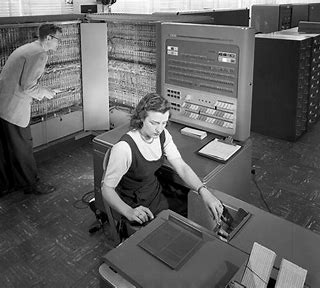

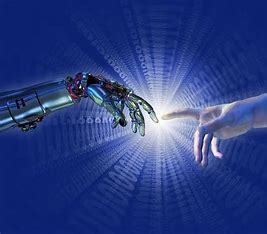

L’intelligenza artificiale e la tecnologia digitale nascono nel 1956, quando alcune persone con provenienze culturali molto diverse si sono trovate dicendo: vogliamo fare una macchina che sia intelligente. Allora c’erano macchinoni che non facevano praticamente niente ma questi signori hanno pensato di fare un qualcosa che potesse risolvere qualsiasi problema. Siccome fin dal tempo dei greci il ragionamento segue la logica, anche l’intelligenza artificiale hanno provato a farla con la logica, la quale sostanzialmente richiedeva che qualcuno scrivesse delle regole e una macchina le eseguisse.

L’intelligenza artificiale e la tecnologia digitale nascono nel 1956, quando alcune persone con provenienze culturali molto diverse si sono trovate dicendo: vogliamo fare una macchina che sia intelligente. Allora c’erano macchinoni che non facevano praticamente niente ma questi signori hanno pensato di fare un qualcosa che potesse risolvere qualsiasi problema. Siccome fin dal tempo dei greci il ragionamento segue la logica, anche l’intelligenza artificiale hanno provato a farla con la logica, la quale sostanzialmente richiedeva che qualcuno scrivesse delle regole e una macchina le eseguisse.

Il ragionamento secondo queste regole funziona molto bene; peccato che quando le regole sono state scritte erano dieci, poi cinquanta, poi cento ma non servivano quasi a nulla. Ne sarebbero servite mille, ma chi è che scrive mille regole? C’è stato allora un momento in cui qualcuno ha detto: mettiamo tutta la conoscenza enciclopedica dentro una macchina che legge tutti i giornali e tutti i libri e riesce a fare qualche cosa. Un progetto di centinaia di anni-uomo finito con un quasi nulla di fatto.

NASCE L’IDEA DELLA IA

Negli anni Ottanta l’intelligenza artificiale doveva risolvere tutti i problemi e non li ha risolti. Ne ha però risolti alcuni ma intanto niente più soldi e niente più ricerca. Nel frattempo però nasceva una nuova idea: se il problema è complesso ed è complesso scrivere le regole costruiamo una macchina che possa imparare a scrivere un modello e possa imparare a fare quello che vorremmo facesse. Da qui è nato tutto un mondo che cerca di fare imparare alla macchina. Non si scrivono più regole ma si vuole che la macchina dia delle soluzioni, imparando. Quella che oggi chiamiamo intelligenza artificiale in realtà sono macchine che imparano e che sostanzialmente fanno un apprendimento automatico: machine learning, ovvero la possibilità di fare costruire dei modelli alle macchine stesse.

Questi modelli devono servire a qualcosa. A cosa? A soddisfare delle esigenze di progettisti e committenti. Ma attenzione; i committenti non pagano se la macchina non fa quello che deve fare e i progettisti hanno un sacco di vincoli. Detto questo cos’è un modello? E’ qualcosa che a fronte di un ingresso di dati e informazioni in qualche modo tira fuori una soluzione, la quale può derivare dal fatto che la macchina capisce qualcosa di quei dati, oppure che con quei dati riesce a fare una previsione o prendere una decisione; insomma a fare qualcosa.

Questi modelli devono servire a qualcosa. A cosa? A soddisfare delle esigenze di progettisti e committenti. Ma attenzione; i committenti non pagano se la macchina non fa quello che deve fare e i progettisti hanno un sacco di vincoli. Detto questo cos’è un modello? E’ qualcosa che a fronte di un ingresso di dati e informazioni in qualche modo tira fuori una soluzione, la quale può derivare dal fatto che la macchina capisce qualcosa di quei dati, oppure che con quei dati riesce a fare una previsione o prendere una decisione; insomma a fare qualcosa.

L’apprendimento automatico fa imparare quel modello, che non deve essere più scritto. Questo ha delle conseguenze importanti che dipendono anche da quello che facciamo per fare imparare questi modelli.

I TRE MODI DI APPRENDIMENTO DELLA IA

Sostanzialmente abbiamo tre modi per fare imparare la macchina e tutto quello che si dice dell’intelligenza artificiale oggi sta dentro questi tre modi.

Il primo: abbiamo degli esempi; ovvero il modo di imparare della macchina è: a fronte dei dati di ingresso diamo degli esempi di cosa ci aspettiamo esca fuori. E di esempi ne diamo migliaia, se non milioni perché la cosa è complessa. Vogliamo trovare quegli aspetti generali che ci permettono di risolvere qualsiasi problema del tipo che corrisponde a quei dati. Quello che fa questo sistema è generalizzare i dati; ma attenzione, generalizzare non vuol dire risolvere in maniera corretta qualsiasi problema ma avere dei modelli che sono mediamente più o meno buoni. Questo si chiama apprendimento supervisionato perché diamo degli esempi

Un altro modo è la macchina che propone un modello e noi diciamo se questo modello va bene o va male, ovvero se a fronte dell’ingresso dei dati i risultati sono quelli attesi. Sulla base del fatto che i risultati siamo siano buoni o no la macchina tiene i risultati buoni e butta quelli non buoni sostituendoli con altri a caso o più o meno simili a quelli buoni e così, prima o poi, avremo solo risultati che risolvono il problema. In questo caso il modo di procedere è diverso: bisogna sapere cosa dire alla macchina cosa va bene e cosa va male.

Un altro modo è la macchina che propone un modello e noi diciamo se questo modello va bene o va male, ovvero se a fronte dell’ingresso dei dati i risultati sono quelli attesi. Sulla base del fatto che i risultati siamo siano buoni o no la macchina tiene i risultati buoni e butta quelli non buoni sostituendoli con altri a caso o più o meno simili a quelli buoni e così, prima o poi, avremo solo risultati che risolvono il problema. In questo caso il modo di procedere è diverso: bisogna sapere cosa dire alla macchina cosa va bene e cosa va male.

Il terzo modo: ci sono alcuni problemi in cui è sufficiente capire quale è la regolarità dei dati, ovvero se c’è qualcosa in comune tra i dati che permette ad esempio di classificarli magari tra decine di caratteristiche diverse che sarebbe difficile maneggiare a mano. Per poter fare questo c’è la statistica.

Questi sono i tre modi per imparare. In tutti i casi quello che facciamo è insegnare alla macchina, ma insegniamo quello che vogliamo noi. Nel primo caso abbiamo dato degli esempi che decidiamo noi. Nel secondo caso decidiamo ancora noi – intendendo il progettista piuttosto che il committente – quali valutazioni dare. Nel terzo caso decidiamo ancora noi cosa è rilevante per i dati e cosa ci interessa mettere assieme. Sostanzialmente siamo sempre noi a decidere ma siccome i modelli sono complessi spesso ci sfuggono un po’ di mano e non riusciamo a capire bene cosa c’è dentro e come viene fuori quello che salta fuori e spesso non riusciamo neppure a governarlo.

Questo è un problema e quindi cerchiamo vi approfondire un po’ meglio.

APPRENDIMENTO SUPERVISIONATO

Riguardo l’apprendimento supervisionato – quello degli esempi – abbiamo tanti pezzetti di programma che interagiscono e vogliono imitare i neuroni cerebrali, infatti si parla di rete neurale. Son tanti ma non come i neuroni, che nella nostra testa sono 36miliardi con 160mila chilometri di connessioni, e quindi questi sistemi per quanto molto complessi sono molto lontani da questo tipo di complessità. Più o meno comunque apprendono come un cervello e sostanzialmente stiamo dicendo che se siamo molto complessi andiamo ad apprendere per livelli di complessità, ovvero ci sono momenti in cui il sistema impara cose più semplici e poi cose sempre più difficili. Ad esempio: per riconoscere che dentro una immagine c’è una automobile un primo livello capirà se ci sono righe ad angolo, delle parti colorate, dei cerchi o altri elementi base per la descrizione dell’immagine; poi c’è un livello successivo in cui si mettono assieme le righe dell’immagine, poi altri elementi e poi altri ancora fintanto non capisce che ci sono delle ruote, dei finestrini e che ruote e finestrini sono automobili. Questo perché è stato dato un esempio di automobile.

Riguardo l’apprendimento supervisionato – quello degli esempi – abbiamo tanti pezzetti di programma che interagiscono e vogliono imitare i neuroni cerebrali, infatti si parla di rete neurale. Son tanti ma non come i neuroni, che nella nostra testa sono 36miliardi con 160mila chilometri di connessioni, e quindi questi sistemi per quanto molto complessi sono molto lontani da questo tipo di complessità. Più o meno comunque apprendono come un cervello e sostanzialmente stiamo dicendo che se siamo molto complessi andiamo ad apprendere per livelli di complessità, ovvero ci sono momenti in cui il sistema impara cose più semplici e poi cose sempre più difficili. Ad esempio: per riconoscere che dentro una immagine c’è una automobile un primo livello capirà se ci sono righe ad angolo, delle parti colorate, dei cerchi o altri elementi base per la descrizione dell’immagine; poi c’è un livello successivo in cui si mettono assieme le righe dell’immagine, poi altri elementi e poi altri ancora fintanto non capisce che ci sono delle ruote, dei finestrini e che ruote e finestrini sono automobili. Questo perché è stato dato un esempio di automobile.

Imagine-net

Il primo grande sforzo che è stato fatto è Imagine-net che contiene 21mila categorie, ovvero 21mila oggetti che riusciamo a far riconoscere all’Intelligenza artificiale mediante la tecnologia digitale riconoscere con 14milioni di immagini etichettate. Ma non tutte le immagini sono correttamente riconosciute: là dove c’è un cane e delle ciliegie la macchina riconosce il cane e non le ciliegie, ma cosa è rilevante? Oppure una tartaruga inquadrata in un certo modo viene scambiata per un coccodrillo. Questo ci comincia a dire che tutto quello che facciamo con questo metodo non è mai al cento per cento sicuro. In qualche modo abbiamo sempre una percentuale di incertezza dovuta a tanti motivi. Siamo soddisfatti quando un sistema ha una accuratezza dell’80-90%, ma qualche volta l’80% è troppo poco.

Per quanto riguarda l’auto autonoma ad esempio abbiamo un sistema che riconosce i cartelli, le persone, le altre auto… Abbiamo cominciato a parlare di auto autonoma negli anni Novanta e sono stati individuati sei livelli di autonomia. Adesso siamo fermi da un bel po’ al due. L’auto riconosce la careggiata, che ha un’auto difronte ma bisogna avere ancora il volante in mano perché non abbiamo ancora il centro per cento dell’affidabilità e può succedere che l’automobile autonoma vada a sbattere contro un camion rovesciato perché nella sua analisi dell’immagine l’auto vede il cassone rovesciato bianco con una riga in mezzo e lo scambia per un orizzonte libero.

Per quanto riguarda l’auto autonoma ad esempio abbiamo un sistema che riconosce i cartelli, le persone, le altre auto… Abbiamo cominciato a parlare di auto autonoma negli anni Novanta e sono stati individuati sei livelli di autonomia. Adesso siamo fermi da un bel po’ al due. L’auto riconosce la careggiata, che ha un’auto difronte ma bisogna avere ancora il volante in mano perché non abbiamo ancora il centro per cento dell’affidabilità e può succedere che l’automobile autonoma vada a sbattere contro un camion rovesciato perché nella sua analisi dell’immagine l’auto vede il cassone rovesciato bianco con una riga in mezzo e lo scambia per un orizzonte libero.

Comunque all’intelligenza artificiale con la tecnologia digitale si riesce a fare tante cose: riconosce che c’è un oggetto abbandonato in mezzo ad un aeroporto, che una persona è caduta, che qualcuno ha fatto dei graffiti, che c’è gente che va in giro mascherata e quindi è potenzialmente pericolosa… E molte di queste cose vengono utilizzate nella sicurezza. Ma possiamo anche riconoscere delle facce o una faccia specifica o delle emozioni. Noi abbiamo fatto un sistema per riconoscere le emozioni dalla faccia e dal corpo. Sono stati predisposti tre sistemi: uno che cerca di riconoscere l’emozione dalle macro espressioni, un altro che cerca di riconoscere le micro espressioni e un altro la posizione del corpo. Ciascuno di essi con i data set, con gli esempi che gli sono stati dati, andava abbastanza bene: all’80-90%. Successivamente li abbiamo messi insieme e visionato dei filmati ma abbiamo visto che tante volte ciò che un sistema capisce l’altro non lo capisce per niente, ma tante volte accade che quando capiscono qualcosa sono cose opposte: uno dice felicità, l’altro rabbia. Perché? Perché come dicevo sono buoni solo all’80-90%

Questa cosa è importantissima. Quanto troviamo qualcosa che è buono al centro per cento diciamo che abbiamo un problema, perchè probabilmente abbiamo dato troppi pochi dati o i dati che abbiamo fornito potrebbero avere dei problemi di bias, di pregiudizio.

Questa cosa è importantissima. Quanto troviamo qualcosa che è buono al centro per cento diciamo che abbiamo un problema, perchè probabilmente abbiamo dato troppi pochi dati o i dati che abbiamo fornito potrebbero avere dei problemi di bias, di pregiudizio.

Un altro rischio connesso alla IA

Un altro esempio (il relatore mostra una slide n.d.r.): sul rischio potenziale di persone arrestate e che potrebbero essere rilasciate sulla base del rischio stimato dall’intelligenza artificiale. Sulla sinistra vediamo persone che hanno basso rischio, sulla destra persone ad alto rischio. Sta di fatto che quelle a destra sono diventate persone tranquillissime e quelle a sinistra hanno fatto di tutto: dal furto all’omicidio. Perché? Perché il data set su cui è stata addestrata la macchina in qualche modo conteneva informazioni negative, ad esempio, sulle persone di colore e siccome sono tante le persone di colore che finiscono in prigione sono tanti anche i casi di recidiva. Questo è grave, perché in generale questo non è vero. Non si può valutare la vita di una persona e dargli la possibilità di riscattarsi fuori dalla prigione sulla base di un sistema di questo tipo. C’è un bias forte.

Purtroppo essere coscienti di questa cosa fino in fondo non è comune e tante volte gli esempi forniti alla macchina sono influenzati dalla cultura che abbiamo. Anche le proposte di Netfix o Amazon sono influenzate dai nostri condizionamenti impliciti e anche se personalmente mi diverto a prendere in giro Amazon perché ordino di tutto Amazon mi propone sempre cose che bene o male c’entrano. Questo perché ogni volta vediamo un film o compriamo qualcosa stiamo fornendo informazioni.

APPRENDIMENTO PER RINFORZO

L’apprendimento per rinforzo è un altro tipo: la macchina apprende sulla base di valutazioni e qualità dei risultati. La macchina fa un’azione, l’ambiente risponde con dei dati ma anche con una valutazione che è calcolata dall’ambiente da una apposita funzione. In presenza di dati complessi una rete neurale interpreta i dati per fornirne una generalizzazione e un’approssimazione (Deep Reinforcement Learning). Con questo sistema si possono fare tante cose: per la guida autonoma si fa ottimizzazione della traiettoria, pianificazione del movimento, ottimizzazione del controllo, politiche di gestione dello scenario; oppure il controllo di robot e ambienti, la gestione finanziaria…

APPRENDIMENTO NON SUPERVISIONATO

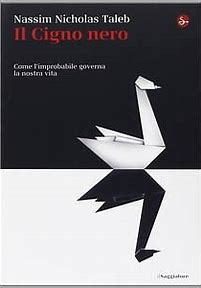

L’apprendimento non supervisionato apprende dalle regolarità che ci sono nei dati basata su criteri di similitudine che diamo noi. Il sistema cerca di classificare i dati sulla base di due sole variabili e in qualche modo cerca di minimizzare la distanza dei dati da un centro classificato Nel caso di venti caratteristiche di calciatori il sistema ad esempio riesce a classificare chi è difensore, chi attaccante, chi mediano; ma ancora una volta non abbiamo il cento per cento di affidabilità perché non esistono soltanto esemplari medi ma anche esemplari che sono dispersi attorno al nostro centro e che sono eccezioni, quindi a rischio di essere discriminati perché non categorizzabili secondo la nostra categorizzazione. Ma talvolta gli esemplari significativi sono proprio quelli che Nicholas Nassim Taleb ha classificato come il “Cigno nero”. Egli porta una quantità di esempi in cui ciò che è rilevante non è nella media: se vogliamo vincere in borsa non dobbiamo giocare come tutti ma in modo diverso.

L’apprendimento non supervisionato apprende dalle regolarità che ci sono nei dati basata su criteri di similitudine che diamo noi. Il sistema cerca di classificare i dati sulla base di due sole variabili e in qualche modo cerca di minimizzare la distanza dei dati da un centro classificato Nel caso di venti caratteristiche di calciatori il sistema ad esempio riesce a classificare chi è difensore, chi attaccante, chi mediano; ma ancora una volta non abbiamo il cento per cento di affidabilità perché non esistono soltanto esemplari medi ma anche esemplari che sono dispersi attorno al nostro centro e che sono eccezioni, quindi a rischio di essere discriminati perché non categorizzabili secondo la nostra categorizzazione. Ma talvolta gli esemplari significativi sono proprio quelli che Nicholas Nassim Taleb ha classificato come il “Cigno nero”. Egli porta una quantità di esempi in cui ciò che è rilevante non è nella media: se vogliamo vincere in borsa non dobbiamo giocare come tutti ma in modo diverso.

IL GENERATIVE ADVERSARIAL NEURAL NERTWORKS

Poi abbiamo qualcosa di più nuovo: il Generative Adversarial Neural Networks (Gann), due reti neurali una attaccata all’altra alle quali dò un testo all’una e una foto all’altra e ciascuna “combatte” con l’altra per dare una uscita buona; in questo caso una descrizione della foto oppure la generazione di una immagine sulla base della descrizione.

Questi sistemi, ed è la cosa importante, non capiscono nulla e quello che fanno è solo mettere assieme tanti dati e minimizzare la differenza che ci può essere tra loro e l’esempio fornito.

Un’altra magia di oggi sono I transformer, usati per elaborazione di linguaggio naturale come nel caso di ChatGPT. Ma attenzione, le risposte non sono sempre giuste. C’è una versione di ChatCPT che permette di programmare e qualche volta io stesso gli chiedo di farmi un certo programma, che però quando lo vado a far girare non fa quello che ho chiesto. Glielo faccio rifare e neppure questo funziona.

Un’altra magia di oggi sono I transformer, usati per elaborazione di linguaggio naturale come nel caso di ChatGPT. Ma attenzione, le risposte non sono sempre giuste. C’è una versione di ChatCPT che permette di programmare e qualche volta io stesso gli chiedo di farmi un certo programma, che però quando lo vado a far girare non fa quello che ho chiesto. Glielo faccio rifare e neppure questo funziona.

I trasformer

Il processo di apprendimento di un trasformer prevede l’utilizzo di una grande quantità di dati e consiste in due fasi principali: un apprendimento non supervisionato in cui impara sostanzialmente come si mette assieme una frase e una fase di apprendimento supervisionato in cui si cerca di mettere a punto le frasi. Tra l’altro ChatCPT oggi è gentilissimo perché questa seconda fase è stata fatta appositamente dopo che nelle prime versioni in cui era stato mandato a fare semplicemente chat in rete dopo due giorni diceva delle cose irripetibili e violente perchè aveva pescato indiscriminatamente dalla rete.

Ma anche ChatCPT , che parla in lingue diverse e fa tante cose non capisce niente anche se genera frasi coerenti con quello che gli viene dato in ingresso; ma di suo non capisce cosa gli sto dicendo e cosa lui mi sta dicendo. E’ un meccanismo che ripete quello che un filosofo degli anni Settanta per l’intelligenza artificiale aveva definito “la stanza cinese”. Supponiamo che dentro una stanza buia ci sia qualcuno che riceve una frase in cinese e ha un libro magico che gli permette di trasformare gli ideogrammi cinesi in alfabeto inglese e tira fuori una frase, ma lui di quella frase in cinese non sa nulla e non capisce nulla.

Non possiamo quindi parlare di intelligenza artificiale se non di capacità di replicare.

Insomma, i trasformer funzionano abbastanza bene, generano post convincenti tanto che secondo un dato del 2021 dal 30 al 60% dei post su Twitter – allora non c’era ancora ChatCPT – erano generati automaticamente. Dunque un sacco di cose, comprese quelle che influenzano le elezioni, sono generate automaticamente.

Insomma, i trasformer funzionano abbastanza bene, generano post convincenti tanto che secondo un dato del 2021 dal 30 al 60% dei post su Twitter – allora non c’era ancora ChatCPT – erano generati automaticamente. Dunque un sacco di cose, comprese quelle che influenzano le elezioni, sono generate automaticamente.

A questo punto però arriviamo alle note dolenti.

LE CRITICITA’

Bisogna considerare i possibili bies, ovvero che i dati non sono esattamente rappresentativi di tutta la popolazione; inoltre anche i possibili bies nella definizione degli obiettivi. Obiettivo di Zuckerberg è mantenere il più possibile le persone attaccate ai suoi prodotti; non è il nostro obiettivo ma noi usiamo i suoi social e stiamo seguendo un sistema che ha quello di obiettivo e questa è una criticità. Inoltre l’algoritmo non è sempre buono perché nessuno ha l’affidabilità del cento per cento. Ma uno dei problemi grossi dell’intelligenza artificiale è che gli utenti e i decisori che usano questi sistemi per assumere le persone o decidere se un progetto è da realizzare o meno, se arrestare una persona o scarcerarla considerano che questi sistemi siano affidabili al centro per cento. Questa è una nostra grossa responsabilità di cui dobbiamo essere coscienti.

E’ un problema che già c’era negli anni Ottanta: che l’intelligenza artificiale risolve tutti i problemi. Abbiamo sentito dire ai nostri politici: usiamo l’intelligenza artificiale. Si ma per fare cosa? Cosa è l’intelligenza artificiale che vorremmo usare?

E’ un problema che già c’era negli anni Ottanta: che l’intelligenza artificiale risolve tutti i problemi. Abbiamo sentito dire ai nostri politici: usiamo l’intelligenza artificiale. Si ma per fare cosa? Cosa è l’intelligenza artificiale che vorremmo usare?

Abbiamo modelli che producono risultati con un certo grado di affidabilità ma come facciamo a sapere se sono buoni o meno? Da un lato ci fidiamo abbastanza degli articoli scientifici e se un modello ha passato il vaglio un po’ ci fidiamo. Spesso però i media riportano notizie senza controllare troppo se sono vere o false, così tante volte si legge sui giornali di cose magiche che non ci sono assolutamente. I media si basano sugli uffici comunicazione dei centri ricerca o aziende, che hanno obiettivi precisi: avere vantaggi economici. I decisori spesso accedono solo ai media e non hanno tempo per gli articoli scientifici o parlare direttamente con gli esperti. Qui entra in gioco la formazione. E’ molto importante capire cosa stiamo facendo, cosa stiamo usando.

Chi è responsabile per un corretto uso dei sistemi di intelligenza artificiale? Da un lato i produttori di tecnologia, dall’altro i venditori e i media che fanno da cassa di risonanza, ma anche noi stessi che compriamo tecnologia e siamo utenti finali. Uno dei problemi di ChatCPT è che effettivamente risponde e ci possiamo andare avanti giorni a parlarci, magari stando giorni chiusi in casa pensando di dialogare con un amico, il quale guarda caso dice proprio quello che sto pensando anch’io.

CONCLUSIONE

In conclusione l’intelligenza artificiale e l’apprendimento automatico sono da un lato strumenti potenti che ci possono migliorare ma dall’altro sono dipendenti da chi li progetta, li costruisce e li usa e non sono affidabili al 100% e siamo tutti responsabili per farne un uso appropriato. Cerchiamo quindi di viverli non come una soluzione finale – e ancora una volta è importante che i decisori capiscano a cosa serve per fare che cosa – perché alla fine ci ritroviamo noi a usare Facebook Amazon ecc. ma poi è il decisore che stabilisce le strategie di mercato o come spendere i soldi pubblici.

In conclusione l’intelligenza artificiale e l’apprendimento automatico sono da un lato strumenti potenti che ci possono migliorare ma dall’altro sono dipendenti da chi li progetta, li costruisce e li usa e non sono affidabili al 100% e siamo tutti responsabili per farne un uso appropriato. Cerchiamo quindi di viverli non come una soluzione finale – e ancora una volta è importante che i decisori capiscano a cosa serve per fare che cosa – perché alla fine ci ritroviamo noi a usare Facebook Amazon ecc. ma poi è il decisore che stabilisce le strategie di mercato o come spendere i soldi pubblici.

L’intelligenza artificiale – che chiamiamo intelligenza ma non è intelligente – è uno strumento che dobbiamo imparare a usare.

_____________________

Andrea Bonarini Laureato in ingegneria elettronica ha conseguito il dottorato di ricerca in Informatica. Insegna al Politecnico di Milano presso Dipartimento di elettronica, informazione e bioingegneria. Dal 1984 è membro del Progetto intelligenza artificiale e robotica del Politecnico di Milano. Ha coordinato il laboratorio di intelligenza artificiale, tecnologia digitale e robotica

Intelligenza artificiale e tecnologia digitale; le altre relazioni pubblicate:

Intelligenza artificiale tecnologia digitale. Carlo Acutis e la dimensione spirituale – Luca Peyron

Intelligenza artificiale e tecnologia digitale. La dimensione etica – prof.ssa Daniela Tafani

Intelligenza artificiale, tecnologia digitale, democrazia e algoterica – Paolo Benanti

Democrazia, Costituzione e intelligenza artificiale – Giulio M. Salerno

Intelligenza artificiale e lavoro che cambia – Ivana Pais